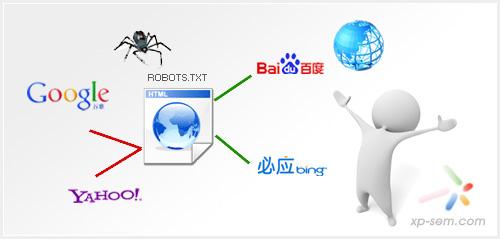

从事seo优化的工作人员必须要了解Robots.txt ,这是一个合格的seoer必须了解的知识。那么,到底robots有什么需要了解的呢?

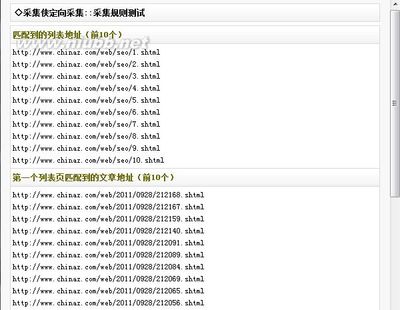

首先,作为一名合格的seo工作人员,必须要了解,Robots.txt是一个协议,而不是一个命令。robots.txt是搜索引擎访问网站的时候要查看的第一个文件。robots.txt文件告诉蜘蛛程序在服务器上什么文件是可以被查看的,以及什么文件是不允许被蜘蛛程序抓取的。

通常情况下,当蜘蛛来到你的网站以后,首先就是要看根目录下是否存在robots.txt这个文件,如果存在,则蜘蛛遵循robots.txt的协议;如果不存在,则蜘蛛会默认爬取网站的所有文件。

了解了这些,想必大家都了解到robots的重要性了,那么到底robot的写法有哪些要点呢?今天烟台腋臭之家就谈一下自己的一些看法:

第一、 robots.txt必须放置在一个站点的根目录下,而且文件名必须全部小写.

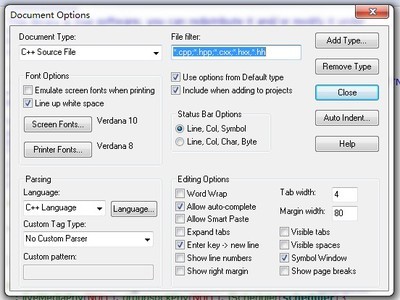

第二、常用命令

User-agent: 定义搜索引擎的类型

Disallow: 定义禁止搜索引擎收录的地址

Allow: 定义允许搜索引擎收录的地址

Sitemap:定义搜索引擎爬取的网站地图的地址

第三、对于User-agent的写法,有些需要注意的方面

User-agent: *

这里的*代表的所有的搜索引擎种类,*是一个通配符。如果要对特定的蜘蛛程序进行限制,则需要改变写法。利于对google蜘蛛添加特定的指令,则需要写成 User-agent: Googlebot ;写成这样的的定义类型,下面再写针对其的特殊协议,如Allow和Disallow等。

第四、Disallow和Allow分别代表禁止抓取和允许抓取,在后边写上相应的地址就可以。如Disallow: /tmp/ ,这样就是要禁止抓取tmp目录了。

而对于要特别限制针对某种类型文件的写法,则需要了解一下$ 这个符号了。$ 代表的是匹配网址的结束字符,如 /.jpg$ ,这样的形式就是表示后缀名为jpg的所有文件了。这样再加上Disallow和Allow命令就可以限制抓取了。

第五、Sitemap的写法

Sitemap的写法必须采用绝对地址,即Sitemap:http://www.xx.com/map.xml ;写成这样的形式才能被蜘蛛读取,如果写成相对地址的形式,则会提示语法错误。

另外,还需要注意的一点,就是Sitemap的网站地图必须要在网站的根目录下才有效。

第六、目前用Robots.txt来限制搜索引擎蜘蛛抓取站点内容的办法只是一种规则,需要搜索引擎蜘蛛的配合才行,并不是每个蜘蛛都全部遵守Robots.txt的。(原创文章,转载请注明转自:http://www.zxiala.net/news/html/558.html 侵权必究)

爱华网

爱华网